Индустрия центров обработки данных (ЦОД) ведёт всё более напряжённую борьбу с перегревом. Современные дата-центры — это промышленные предприятия, преобразующие практически каждый ватт потребляемой электроэнергии в тепло. Дело в том, что кроме традиционных задач для серверных решений, всё больше производственных компаний используют вычислительные мощности для моделирования в различных средах. Моделирование больше не является просто вспомогательной функцией в инженерии — оно становится движущей силой разработки продукции. Соответственно, востребованность размещения серверов в ЦОДах растёт.

Кроме того, имитационное и конструкторское моделирование распространяется на тестирование и виртуализацию сложных интеллектуальных систем для автомобильной промышленности, в области автоматизированного проектирования электронных устройств и других отраслей. Компании переходят от автономных инструментов к полноценным платформам проектирования — им необходимо мультифизическое моделирование, масштабируемое от отдельных компонентов до целых систем. Гибридные цифровые двойники, объединяющие реальные данные с результатами моделирования, набирают популярность, особенно для моделирования редких пограничных случаев. Проверка различных итераций тепловых, механических и материальных процессов имеют решающее значение.

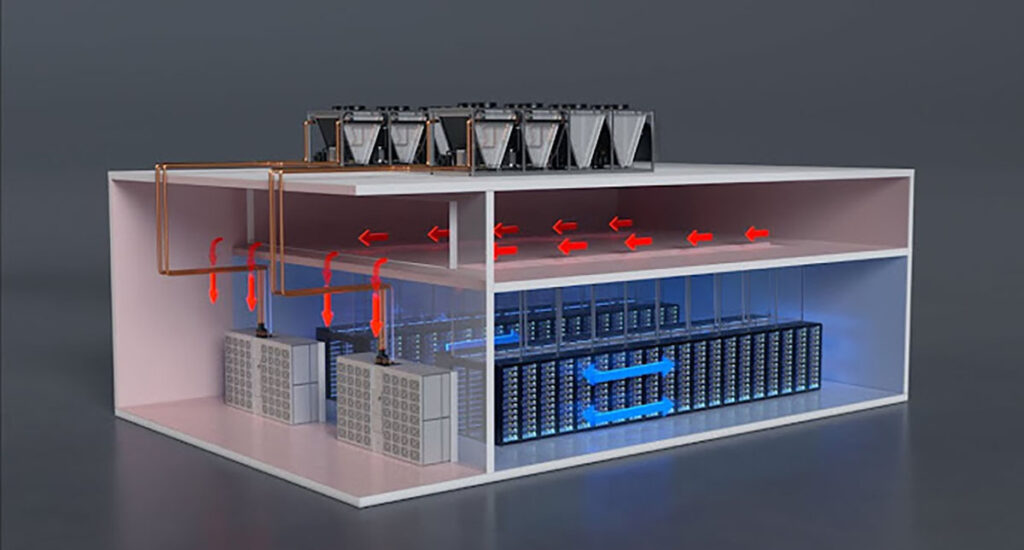

В основе таких высоконагруженных процессов лежат от сотен до десятков тысяч серверов в стойках, которые объединяют вычислительные мощности центральных процессоров, оперативной памяти, хранилищ большого объёма данных, сетевое оборудование и источники питания. В связи с новыми потребностями для обучения и вывода искусственного интеллекта (ИИ) на новые уровни, плотность стоек быстро растёт, масштабируясь от 10 кВт до более чем 120 кВт на стойку. Чтобы удовлетворить растущий спрос на электроэнергию и необходимость отвода тепла, требуется новый подход.

Недостаточно просто улучшить статус-кво — пора задуматься над тем, как полностью изменить правила игры. Отрасли нужен мощный инструмент — нечто, что радикально повысит производительность и эффективность всей системы охлаждения.

Хотя охлаждение всегда было сдерживающим фактором, темпы изменений и масштабы современных проблем с отводом тепла от серверных стоек привели к тому, что традиционная инфраструктура воздушного охлаждения устарела. Сегодня охлаждение представляет собой второй по величине компонент капитальных затрат (после энергетической инфраструктуры) и является самой крупной статьёй операционных расходов, не связанных непосредственно с информационными технологиями. Это также область с самой крутой кривой обучения, самым высоким операционным риском и самыми значительными возможностями для повышения эффективности и инноваций.

Традиционным показателем оценки энергоэффективности в центрах обработки данных является коэффициент PUE (Power Usage Effectiveness). В то время как средний показатель по отрасли составляет около 1,6 ведущие компании, имеющие свои современные дата-центры, работают с коэффициентом, приближающимся к показателю 1,1. Они достигают столь низких значений PUE за счёт активной экономии воздуха, термоизоляции и оптимизации вычислительной гидродинамики. Но и у этого подхода есть ограничения, к которым они быстро приближаются. Такие чипы, как Nvidia H100, уже достигают тепловой проектной мощности (TDP) 700 Ватт, а будущие модели превышают 1500 Вт.

Но проблема не только в мощности, но и в геометрии и термодинамической эффективности. Воздушное охлаждение, даже оптимизированное, имеет ограниченную теплопередачу. Для перемещения достаточного количества воздуха в целях охлаждения стоек мощностью более 100 кВт требуются массивные вентиляторы, воздуховоды и значительное пространство. Стойки с воздушным охлаждением в идеальных условиях достигают максимальной мощности 40–50 кВт.

Всё, что выходит за эти рамки, требует компромиссов: мощность вентилятора экспоненциально растёт с увеличением воздушного потока, форм-факторы стоек становятся громоздкими, а риск перегрева и выхода из строя компонентов возрастает. Теплообменники на задней двери могут дополнительно улучшить охлаждение, но увеличивают сложность конструкции, капитальные затраты и эксплуатационные расходы вентиляторов.

Потребности в охлаждении и общее энергопотребление неразрывно связаны. Ожидается, что энергоёмкие гипермасштабируемые компании потратят более 1 трлн долларов капитальных затрат в течение следующих пяти лет, при этом тепловые характеристики станут основным фактором, определяющим этот процесс. За тот же период, согласно прогнозам, потребность в электроэнергии для центров обработки данных утроится, увеличившись с 4,4% до 12% от общего потребления электроэнергии. В Европе ожидается рост ИТ-нагрузки примерно с 10 Гигаватт до 35 ГВт. Проще говоря, масштабный рост стимулирует перестройку всей архитектуры сетей.

Экологические и нормативные факторы также усиливают необходимость внедрения более экологичных решений для отрасли центров обработки данных. В соответствии ними, инфраструктура охлаждения теперь должна соответствовать стандартам энергоэффективности, углеродной ёмкости и водопотребления. Эти показатели стали значимым фактором при закупках, особенно в государственных и промышленных целях.

В более широком смысле, спрос на энергоэффективные модели развертывания вычислительных систем высокой плотности не ограничивается гиперскейлерами. Операторы связи, промышленные предприятия, крупные государственные учреждения и исследовательские организации приходят к одному и тому же выводу: жидкостное охлаждение — это не оптимизация, а необходимое условие.

В этом году прогнозируют быстрый переход к архитектурам жидкостного охлаждения на уровне корпуса и непосредственно на кристалле, обусловленный требованиями ИИ, периферийных вычислений и устойчивого развития. Ожидается, что расходы на жидкостное охлаждение будут расти среднегодовыми темпами на 14%, превысив 61 миллиард долларов к 2029 году, несмотря на то, что системы охлаждения на уровне кристалла и системы полного погружения сталкиваются с ограничениями по масштабируемости и обслуживанию.

Сам принцип жидкостного охлаждения меняет правила игры. Вода и диэлектрические жидкости способны поглощать в тысячи раз больше тепла на единицу объёма, чем воздух, что позволяет создавать гораздо более компактные и эффективные системы. Именно поэтому система Nvidia GB200 NVL72, являющаяся стандартом инфраструктуры искусственного интеллекта, разработана специально для прямого жидкостного охлаждения процессора (DTC). И она не одинока. Другие компании тоже ускоряют внедрение систем охлаждения DTC, интегрируя их в новые сборки или модернизируя в оптимизированные для воздуха залы обработки данных. Однако такой путь модернизации чреват неэффективностью.

Текущая реакция отрасли на рост тепловых нагрузок фрагментирована, и рынок быстро приближается к переломному моменту. Сегодня операторы внедряют разнообразные «мостовые» решения: боковые системы с жидкостно-воздушным охлаждением (L2A), модернизацию RDHx и гибридные системы «воздух-жидкость». Хотя эти временные меры могут обеспечить краткосрочное внедрение графических процессоров, они сопряжены с высокими затратами, высоким потреблением воды и долгосрочными проблемами масштабируемости. В конечном итоге, они не способны поспевать за быстрым темпом инноваций.

По мере того, как Nvidia и другие компании переходят на 1-мегаваттные стойки и разрозненные системы электропитания/охлаждения, модели модернизации охлаждения перестают работать. Анализ совокупной стоимости владения (TCO) самой Nvidia показывает, что решения L2A являются самым дорогим из доступных вариантов, как из-за капитальных затрат, так и из-за эксплуатационной неэффективности. Требования к охлаждению и электропитанию систем текущего и следующего поколений вынуждают отрасль полностью переосмысливать проектирование объектов.

Однако времени на создание инфраструктуры, поддерживающей следующее поколение чипов и серверов, остаётся всё меньше. Вместо того, чтобы перескакивать с одной платформы (воздушное охлаждение) на другую (непосредственное охлаждение чипов), отрасли необходимо полностью пересмотреть подход к управлению теплом.

Технология полного погружения в резервуар практически не применяется из-за её высокой сложности и дороговизны в развёртывании и обслуживании, оставляя лишь один очевидный путь развития: автономное жидкостное охлаждение на уровне сервера. Она сочетает в себе тепловую эффективность полного погружения в резервуар с более низкими затратами на внедрение, улучшенным удобством обслуживания и значительно сниженным воздействием на окружающую среду. Что самое важное, он обеспечивает наиболее жизнеспособное и экономически эффективное долгосрочное решение для охлаждения будущих поколений компьютерного оборудования.